Model Description

VARCO LLM 2.0은 텍스트 생성, 질의응답, 챗봇, 요약, 정보추출 등 다양한 자연어처리 기반 AI 서비스 개발에 적용할 수 있는 Large Language Model입니다. NC는 VARCO LLM 2.0 개발을 위해 데이터 구축 및 사전학습(Pre-training), 미세조정(Instruction Tuning), 정렬조정(Alignment Tuning)까지 모두 자사의 기술로 개발되었습니다. 새로운 VARCO LLM 2.0은 다양한 NLP 태스크에서 성능을 측정한 결과, VARCO LLM 1.0 대비 성능이 크게 향상되었으며, 비슷한 규모의 한국어 LLM 모델 중 가장 높은 성능을 자랑합니다. 특히, 창의적인 글쓰기, 요약, 질의 응답, 챗봇, 번역 등 고수준의 자연어처리 응용 분야에서 활용될 수 있도록 학습되었고, 관련 정량 지표에서도 높은 성능을 보여줍니다.

이제 고객들은 AWS 플랫폼 내에서 자신만의 고유의 데이터를 가지고 SageMaker를 사용하여 커스터마이징 할 수 있습니다.

앞으로도 지속적인 모델 업데이트를 지원하고, 특정 작업에 맞게 조정된 LLM도 출시할 예정입니다.

추가 성능 개선이나 서비스 적용을 위한 협업 관련 문의는 이메일(varco_llm@ncsoft.com)로 문의하시기 바랍니다.

2024년 - VARCO LLM 2.0

- VARCO LLM 2.0은 실제 사용성 향상을 위해 생성 성능에 중점을 두고 모델을 개선하였습니다.

- VARCO LLM 1.0에 비해 더 많은 학습 데이터로 사전학습 및 Instruction Tuning을 진행하였으며, 자체 구축한 Human Feedback 데이터셋으로 Alignment Tuning을 수행하였습니다.

- 이전 모델 대비 컨텍스트 길이가 2배 확장 되었습니다. (2k -> 4k)

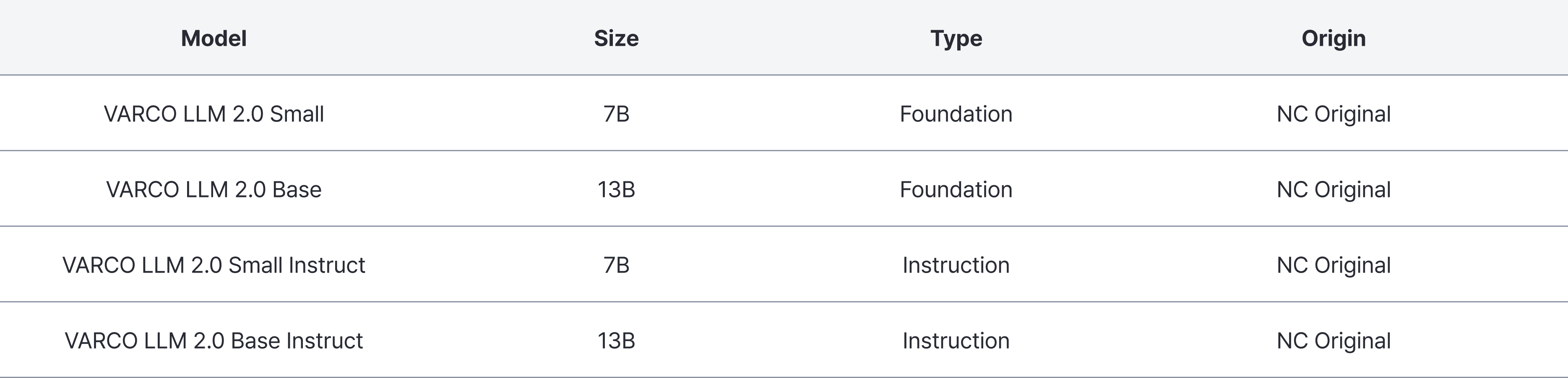

VARCO LLM 2.0 Small

- VARCO LLM 2.0 Small은 빠르고 효율적인 고성능 소형 언어 모델입니다.

- 한국어, 영어에 능통하며, 중국어, 일본어 능력도 우수합니다.

- 4k 컨텍스트 길이를 지원합니다.

- Instruction 모델은 Multi-turn을 지원합니다.

VARCO LLM 2.0 Base

- VARCO LLM 2.0 Base는 복잡한 NLP 태스크를 더욱 뛰어난 품질로 수행 가능한 중형 언어 모델입니다.

- 챗봇, 번역, QA 등 대부분의 NLP 태스크에서 뛰어난 성능을 보이는 고성능 언어 모델입니다.

- 한국어, 영어에 능통하며, 중국어, 일본어 능력도 우수합니다.

- 4k 컨텍스트 길이를 지원합니다.

- Instruction 모델은 Multi-turn을 지원합니다.

Training Datasets

- 1.0 대비 약 4.5배 더 많은 학습 데이터로 사전 학습하였습니다.

- 1.0 대비 10배 더 많은 학습 데이터 구축 및 Instruction Tuning으로 다양한 태스크의 지시문을 잘 이해합니다.

- AI 윤리 등 자체 구축한 고품질 Alignment Dataset으로 Alignment Tuning으로 사용자들의 선호도를 반영하였습니다.

VARCO LLM 2.0 성능 평가 지표

NC에서는 LLM 한국어 생성 능력을 평가하기 위해 아래의 두 가지 벤치마크를 통해 VARCO LLM의 성능을 평가하였습니다.

- MT-Bench (Link) : Multi-turn 대화를 통해 생성 능력 평가

- 코딩, 정보 추출, 인문, 수학, 추론, 역할극, STEM, 글쓰기 8가지 카테고리의 Multi-turn 프롬프트 80개로 구성

- LogicKor 벤치마크 (Link): 한국어 언어모델에 대한 다양한 분야에서의 사고력 평가

- 추론, 수학, 글쓰기, 코딩, 이해, 국어 6가지 카테고리의 Multi-turn 프롬프트 42개로 구성

(두 벤치마크 모두 해당 벤치마크 평가 페이지에서 제공하는 템플릿에 맞춰 평가하였으며, 평가 모델은 gpt-4-1106-preview로 진행)

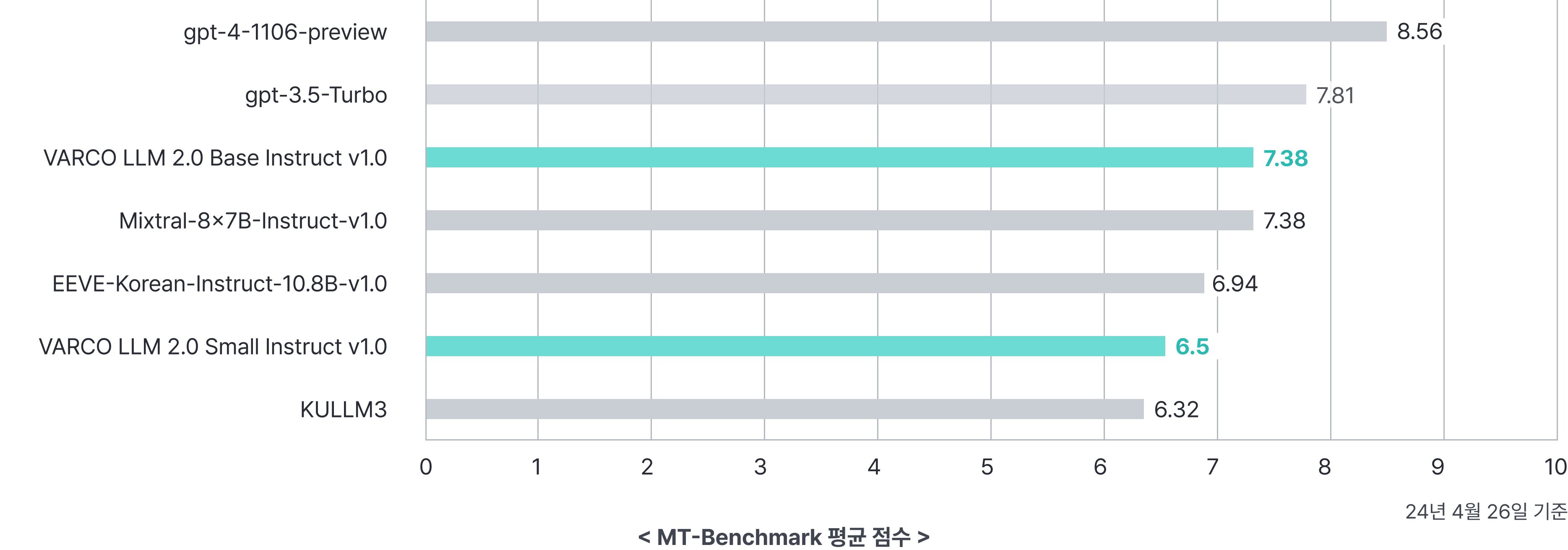

MT-Benchmark 결과

MT-bench에서 VARCO LLM 2.0 Small Instruct 모델은 유사한 크기 중에서 가장 높은 성능이며, 일부 큰 모델들 보다도 좋은 성능을 보이고 있습니다.

VARCO LLM 2.0 Base Instruct 모델 역시 유사한 크기의 모델들 중 가장 우수한 성능을 가지며, GPT-3.5 Turbo와 비교하여도 견줄만한 성능을 가지고 있습니다.

(MT-bench 평가 로그 다운로드 : VARCO LLM 2.0 Small Instruct v1.0 , VARCO LLM 2.0 Base Instruct v1.0)

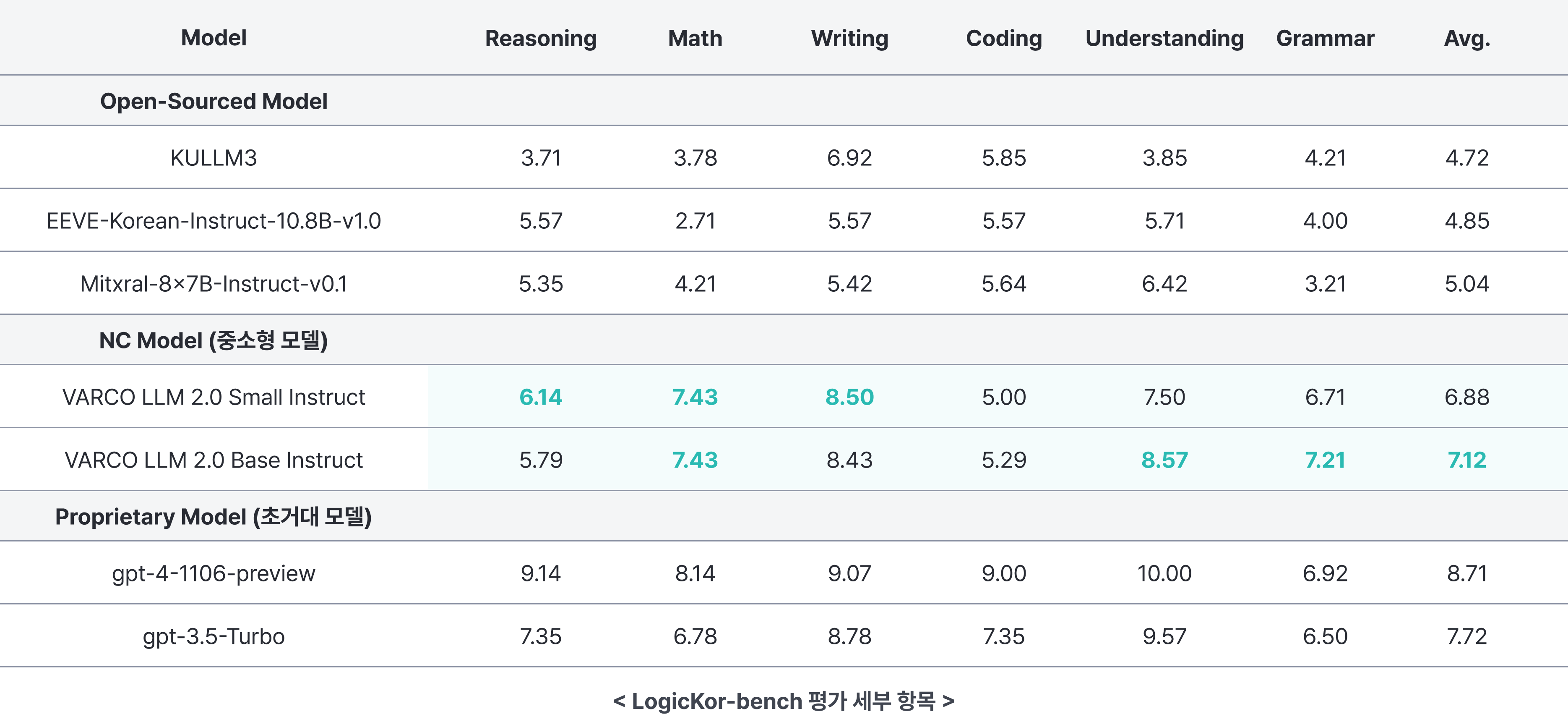

LogicKor Benchmark 결과

LogicKor-Bench에서도 VARCO LLM은 동일 크기 모델 대비 최고 성능을 보이고 있으며, VARCO LLM 2.0 Base Instruct는 GPT-3.5-Turbo와 비교하여도 견줄만한 성능을 보이고 있습니다. Reasoning, Understanding 뿐 아니라 이메일, 광고 기획, 스토리 생성 등 Writing에 강합니다.

(LogicKor-bench 평가 로그 다운로드 : VARCO LLM 2.0 Small Instruct v1.0 , VARCO LLM 2.0 Base Instruct v1.0)